當(dāng)今���,全球每分鐘的網(wǎng)絡(luò)交易量近9000萬筆���,也就是每秒鐘交易150萬次���。全部的電子郵件、應(yīng)用下載���、流視頻��、社交媒體交互����、零售購買等等��,都是通過一個全球性的數(shù)據(jù)中心網(wǎng)絡(luò)來實(shí)現(xiàn)的�����。在交換機(jī)��、路由器及冷卻設(shè)備所構(gòu)成的網(wǎng)絡(luò)的支持下,這些數(shù)據(jù)中心可以容納多達(dá)1萬臺的服務(wù)器–而這一切都要依靠越來越多的電力才能良好運(yùn)行��。

一���、電力的轉(zhuǎn)換和分配

數(shù)據(jù)中心采用一種稱為“電源單位效率”的方法來評估電源架構(gòu)的效率���,也稱為PUE。PUE是將輸送到數(shù)據(jù)中心的總功率除以輸送到關(guān)鍵負(fù)載(服務(wù)器)的功率����,而理想的PUE值為 1。舉例來說�����,1.7的PUE意味著�����,每向負(fù)載輸送一瓦的功率�����,在配電和冷卻上就要損失掉0.7瓦����。據(jù)報道���,2018年對數(shù)據(jù)中心測得的PUE水平在1.6左右�。最重要的轉(zhuǎn)換過程之一就發(fā)生在機(jī)架上。為了達(dá)到所需的計(jì)算能力�����,會需要數(shù)千臺的服務(wù)器��。除了服務(wù)器以外�,還通過交換機(jī)來管理服務(wù)器之間、以及從服務(wù)器到外界的通信��。在大量的電力所輸送到的機(jī)架上����,容納著30到35臺的1U服務(wù)器,這些服務(wù)器正在逐步通過3千瓦的供電機(jī)組(PSU)來供電���。PSU通常位于機(jī)架的底部����,可以將電力轉(zhuǎn)換成電壓水平各不相同的電源軌。以208伏直流電壓進(jìn)入到 PSU 的電力將轉(zhuǎn)換為 3.3�、5和12伏的電源軌,從而滿足服務(wù)器和交換機(jī)內(nèi)部各種不同組件的需求����,例如含處理器的母板、適配器卡和顯卡���、PCIe 和內(nèi)存等等�����。此外���,機(jī)架中還會有提供冷卻氣流所需的大量風(fēng)扇。輸送到服務(wù)器的很大一部分電力都會轉(zhuǎn)換成熱量��。在電力從交流轉(zhuǎn)換成直流�、以及從直流轉(zhuǎn)換成直流的過程中,作為轉(zhuǎn)換過程中一個自然而然的組成部分���,就會發(fā)生這種熱損失����。

二、空間上的挑戰(zhàn)

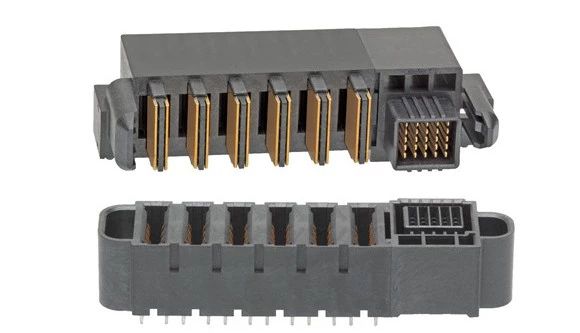

對這種與日俱增的功率進(jìn)行管理��,在涉及到封裝空間和熱管理時�����,就會產(chǎn)生巨大的挑戰(zhàn)����。盡管對電源的需求一直在穩(wěn)步提升����,為電源以及背部的重要連接器分配的空間卻并沒有發(fā)生過變化?;氐椒?wù)器部署的早期時候,服務(wù)器系統(tǒng)基礎(chǔ)設(shè)施(SSI)要求使用400到600瓦的電源���,而電源I/O則會使用四到六臺葉片式電源�,其中每個葉片的額定電流為30安�,從而將所需的功率輸送到服務(wù)器。時至今日�,對于連接器企業(yè)的要求則是電源I/O在相同空間內(nèi)承載的電流能夠達(dá)到以前的三倍。

三���、提高密度

連接器的設(shè)計(jì)人員現(xiàn)在不得不去考慮各種具有創(chuàng)造性的解決方案�����,從而對熱量和電流進(jìn)行管理�。盡管在連接器的額定值計(jì)算中不能將氣流考慮在內(nèi),目前在外殼中經(jīng)常會設(shè)計(jì)通風(fēng)功能���,以便耗散掉熱量并防止過熱��?�;A(chǔ)的物理學(xué)知識告訴我們����,為了承載更多的電流�����,需要的只不過是更多的銅材料�����。在銅合金領(lǐng)域取得的進(jìn)步使得可以提高導(dǎo)電性,而這些進(jìn)步并不會跟得上對更高電流密度的需求�����。同樣����,觸點(diǎn)設(shè)計(jì)上的改進(jìn)可以改善PSU 接口和連接點(diǎn)之間經(jīng)常發(fā)生的功率損耗的情況,這種連接點(diǎn)可能是互連系統(tǒng)的插入部分�����,有時候也會是印刷電路板的卡邊緣��,但是并不能依靠這些改進(jìn)成果來顯著的提高電流密度����。廣大的客戶目前正要求連接器的設(shè)計(jì)人員來減小電源觸點(diǎn)之間的中線間距�;然而,縮小間距會在印刷電路板的體積上以及連接器本身的內(nèi)部造成相互發(fā)熱的問題�����。連接器在過去40年來主要圍繞著提高密度而發(fā)展�����。但是,業(yè)界現(xiàn)在正在走向這樣一個階段����,那就是必須考慮增加空間以提高功率,或者是對用于評估連接器性能和額定值的慣例進(jìn)行檢驗(yàn)���。據(jù)認(rèn)為����,數(shù)據(jù)中心的電效率每提高1%��,就會節(jié)省數(shù)以百萬美元計(jì)的成本���。由于節(jié)省成本的潛力是如此之大����,在數(shù)據(jù)中心的業(yè)主����、電氣公用事業(yè)的提供商以及政府官員之間,那場積極活躍的討論當(dāng)然還會繼續(xù)進(jìn)行一段時間����。